高效能、低功耗、 架构弹性

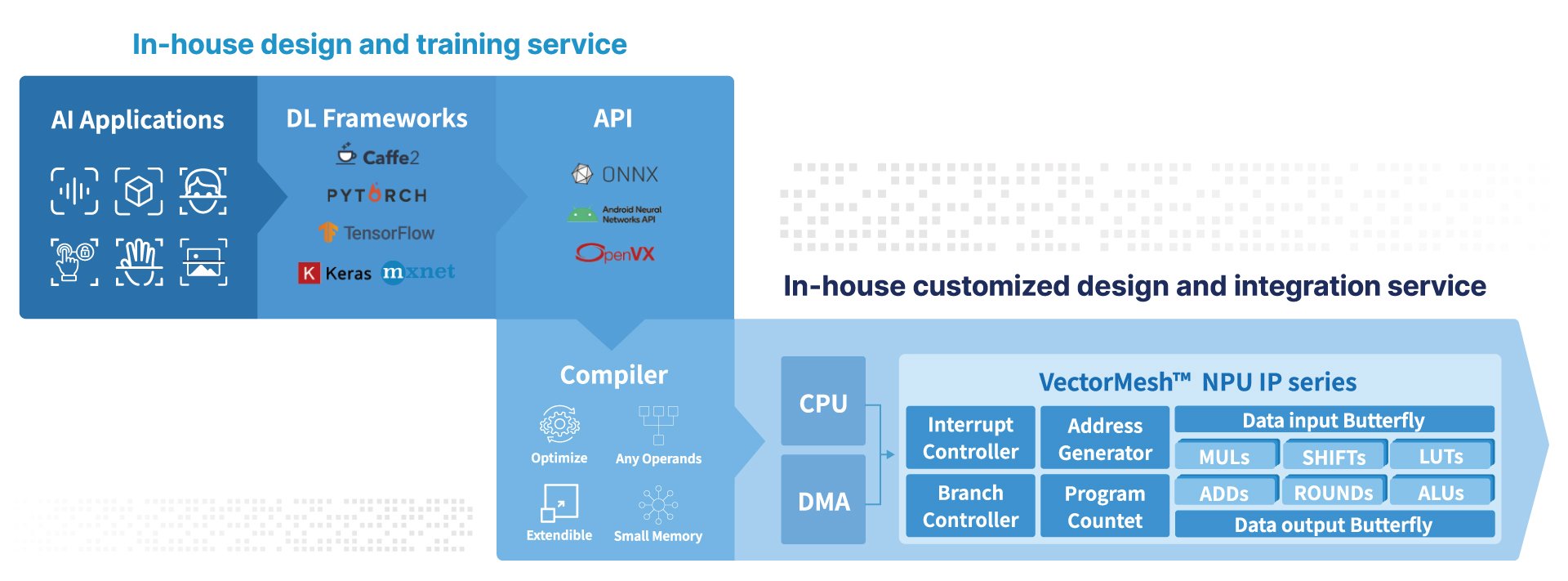

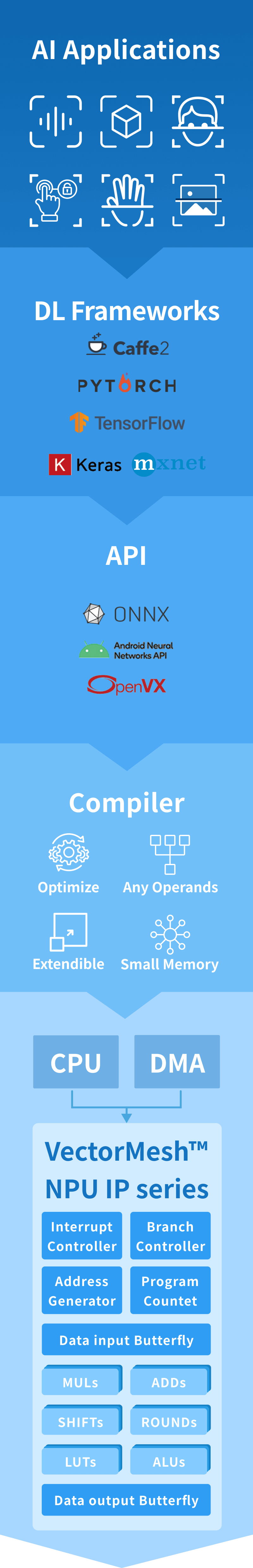

「 VectorMesh™ 」 NPU IP

为颠覆传统处理器架构所设计,使用独特创新技术优化资料传输的时序、提升资源利用率,不仅达多倍运算能力,逻辑闸 (Gate count) 数量在相同制程与运算能力条件之下,更是少了同级产品 4 倍之多。

架构的灵活性可支持不同数据精度运算 (8~16位元) ,并能够依据晶片规格进行客制化设计,大量减少非必要的额外资源。

- 效益优先:架构自始为追求卓越 PPA (Power/Performance/Area) 指标所构思,成就兼具高性能、低功耗的 NPU。

- 量身打造:弹性架构具备高相容与扩展能力,可为系统所需进行客制化设计。

低成本、低功耗

实现多样、高效能的 AI 应用

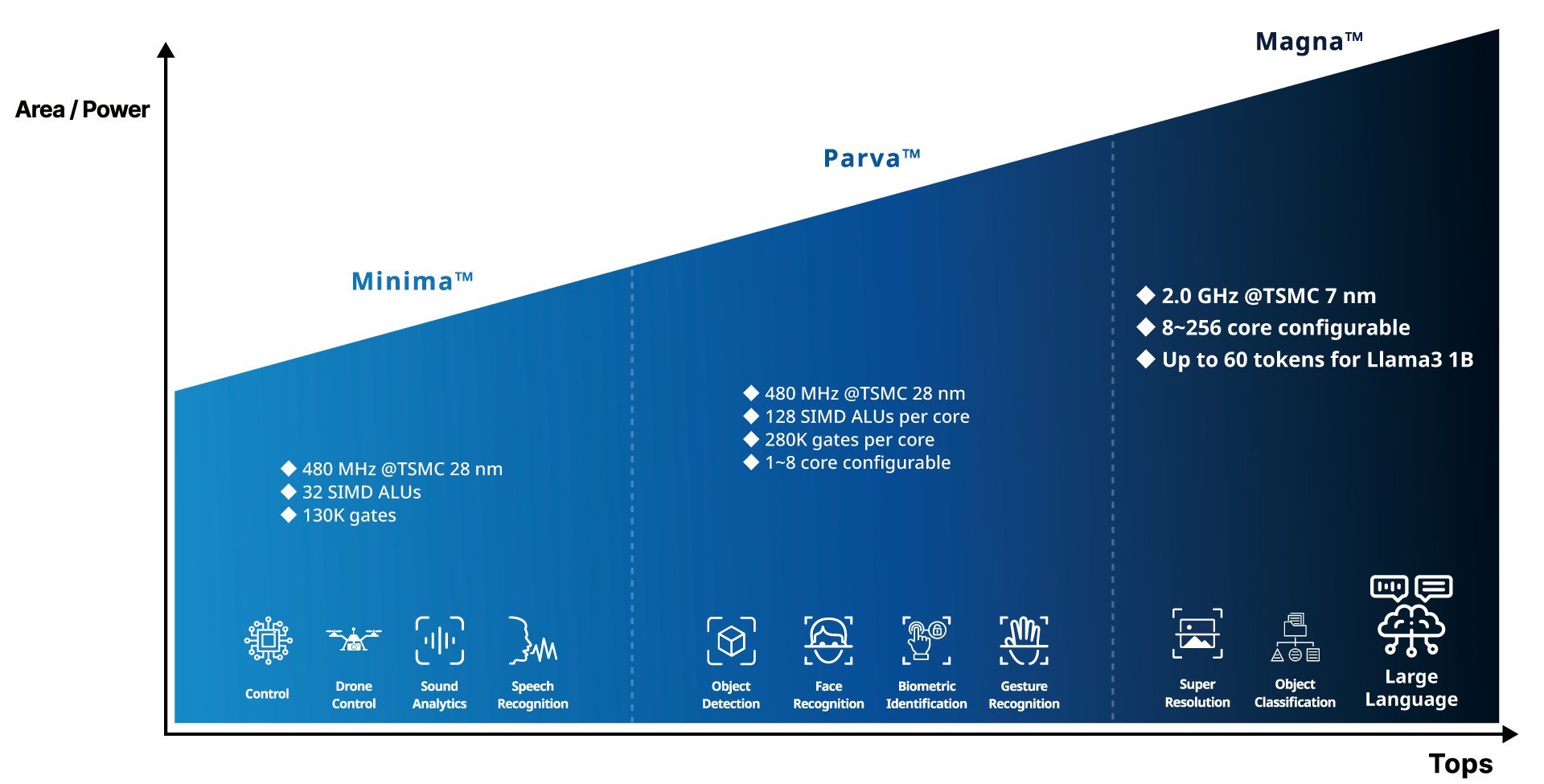

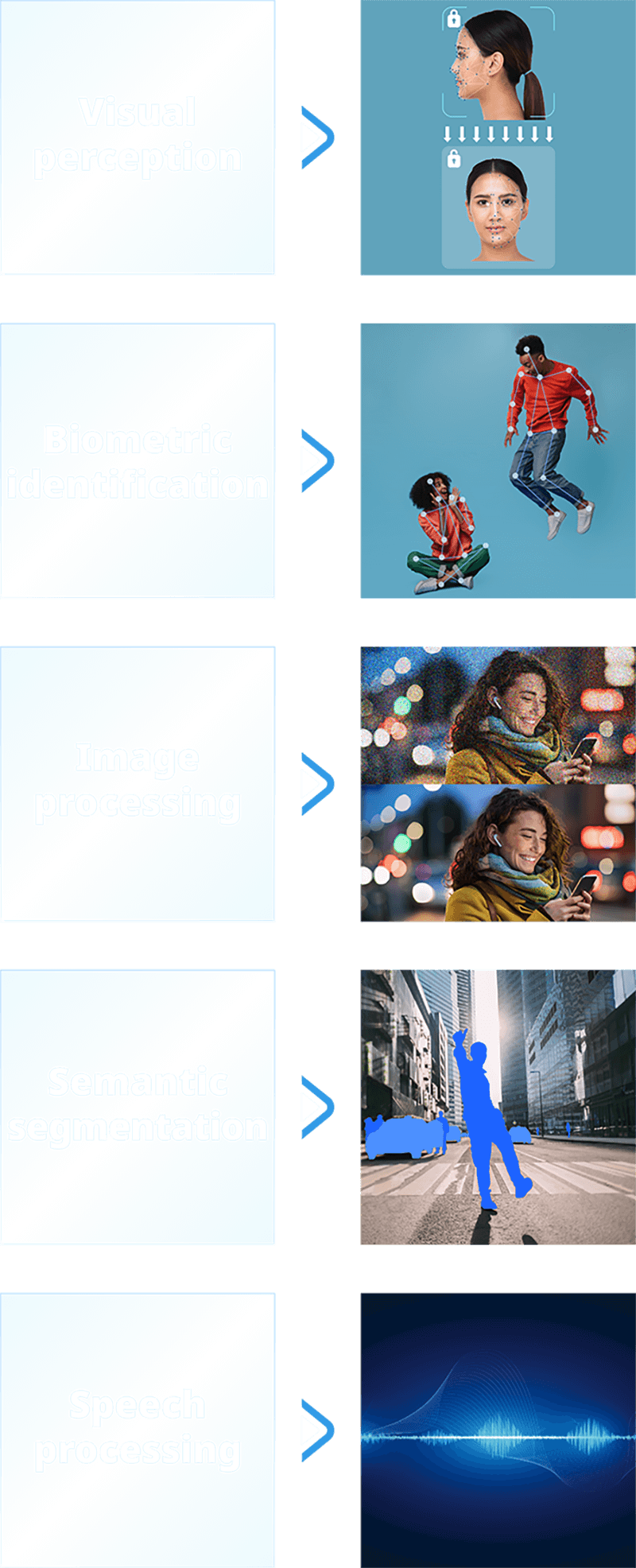

完全自主研发的弹性架构,支援 MobileNet、SSD、YOLO、Wav2vec 、TDNN 等系列之 AI 模型,能以更低的成本与功耗实现 AI 运算,可广泛应用于视觉感知、图像处理与增强、语音处理、生物识别等领域,为 AI 边缘运算领域之首选 NPU IP。

- 客制服务:结合英业达 AI 研究中心 6 年实战经验,提供专业AI 模型设计与训练,满足各种应用场景。

- 视觉感知领域:物件侦测、人脸侦测、人脸辨识、手势辨识、姿态辨识、视频分析、视频推论等。

- 图像处理与增强领域:杂讯过滤、图像校正、图像分割、超分辨率、图像风格转换等。

- 语音处理领域:语音侦测、语音辨识、语音特征分析、语音控制等。

- 生物识别领域:身形辨识、步态辨识等。

首屈一指的 AI 应用一站式服务

缩短验证加速上市

以往购买 NPU 授权后,还需要另外花时间或人力取得 AI 模型训练与编译服务?选择 VectorMesh™ 嵌入式神经网络处理器,能同时拥有稳定的高效软体开发工具链。

AI 模型设计与训练、AI 模型编译及 SoC 整合到晶片等阶段,一站式的服务能以全方位式进行系统整合,缩短交叉验证时间,提高成本效益,加速 AI 晶片量产抢攻市场。

- 效率第一:效率驱动的一站式 IP 导入服务,加速系统整合效率与降低风险。

- 资源最大化:省下宝贵人力与时间资源,交给反应速度快、具备专业分工的英业达 VectorMesh™ 开发团队。